cookies應對python反爬蟲知識點詳解

在保持合理的數據采集上,使用python爬蟲也并不是一件壞事情,因為在信息的交流上加快了流通的頻率。今天小編為大家帶來了一個稍微復雜一點的應對反爬蟲的方法,那就是我們自己構造cookies。在開始正式的構造之前,我們先進行簡單的分析如果不構造cookies爬蟲時會出現的一些情況,相信這樣更能體會出cookies的作用。

網站需要cookies才能正常返回,但是該網站的cookies過期很快,我總不能用瀏覽器開發者工具獲取cookies,然后讓程序跑一會兒,每隔幾分鐘再手動獲取cookies,再讓程序繼續跑吧。如果反復這樣工作,那么寫爬蟲也就沒意義了。便開始對cookies進行分析。

從瀏覽器的開發者工具獲取到的cookies大約有10個字段,經過反復測試,能讓網站正常返回的只需要兩個字段,分別為__jsluid_h=011a522dbxxxxxxxxc1ce59d336e5e60和__jsl_clearance=1581880640.794|0|trTB4c6b%2BZpvxxxxxxxx8YqCOOo%3D (中間打碼處理)。

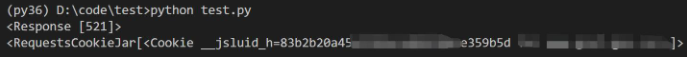

經過測試,如果請求的時候不自己構造cookies,默認會返回__jsluid_h :

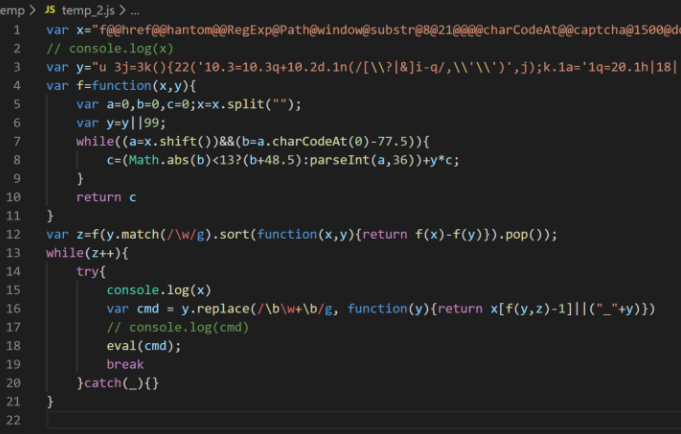

先嘗試了將那段js腳本保存下來,包裝成一個html文件打開,發現瀏覽器不停的刷新,也并沒起什么作用。那就分析一下js腳本,原來的代碼是單行的,自己整理一下并加了一些變量名和log,大概是這么個樣子:

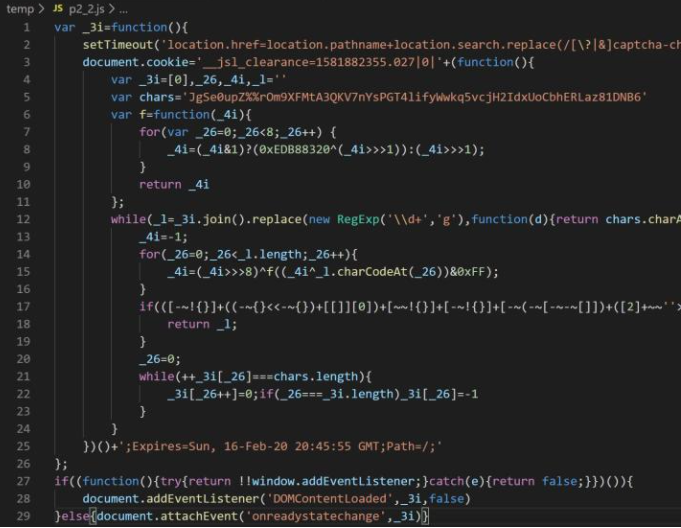

將第16行的變量cmd打印出來看看,發現是另一段類似的腳本:

可以看到第二段腳本已經開始設置cookies的__jsl_clearence 字段了。這些顯然就是混淆后的js腳本,但是分析到這里也就大概弄明白了從發送請求到網站返回是怎么回事。之所以在本地跑這段代碼會不斷刷新,是因為第二行的setTimeout會讓其在1.5秒后重新請求,但是我們本地沒有服務處理請求讓其停止,所以會不斷的刷新。

而第一段腳本當中,變量y是完整的js代碼 ,代碼中的變量名和關鍵字被進行編碼了,變量x存儲的是用來替換的變量名和關鍵字,后面是解碼函數。所以現在的問題變成了獲取第一段腳本當中的cmd代碼,執行后再獲取第二段代碼的document.cookie的內容即可。

可是對于python和js的交互我完全沒接觸過,嘗試了PyExecJS和Js2Py,都沒辦法正常執行第一段腳本。無奈之下,我用python復現了第一段腳本,然后用Js2Py獲取了cookie。在請求一次過后,構造cookies,再請求一次,就可以了:

def test(): url = REQUEST_URL # url = ’https://www.baidu.com’ request_header = get_header() html = requests.get(url, headers=request_header) print(html) jscode = html.text # print(jscode) # tryjs.get_cookies()為復現的js代碼,以及用Js2Py獲取cookies的代碼 request_cookies = try_js.get_cookies(jscode) request_cookies += ’;__jsluid_h=’ + html.cookies[’__jsluid_h’] request_header[’Cookie’] = request_cookies print(request_header) html = requests.get(url, headers=request_header, timeout=5) print(’new connection’) print(html) print(html.text)

在經歷重重的分析試驗后,我們終于得出以上的代碼成功實現了構造cookies。相信經過本篇的學習,小伙伴們又多了一種解決爬蟲阻攔獲取數據的cookies辦法了,趕快行動起來吧。

到此這篇關于cookies應對python反爬蟲知識點詳解的文章就介紹到這了,更多相關如何構造cookies應對python反爬蟲內容請搜索好吧啦網以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持好吧啦網!

相關文章:

網公網安備

網公網安備